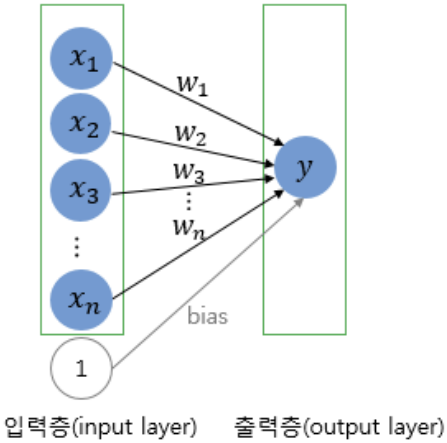

Perceptron 구조

입력층(input layer)과 출력층(output layer)으로 구성

Single-Layer Perceptron (단층 퍼셉트론)

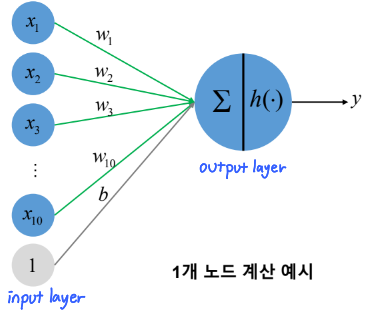

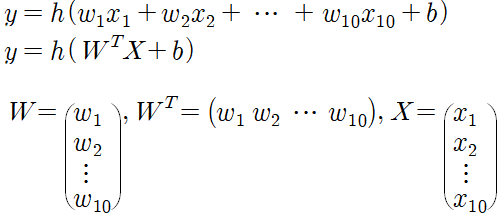

▪ 각 입력(x)에 대응되는 weight(w), 1개의 노드에 입력되는 bias(b)존재

▪ 가중합으로 얻어진 결과치에 활성화 함수(h) 적용

▪ 층 수 : 1개

→ 모델의 층 수를 셀 때, 보통 입력층은 생략함. 따라서, 1개의 층을 갖는다.

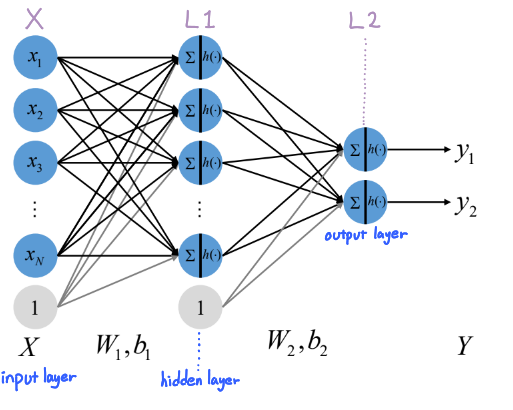

Multi-Layer Perceptron (MLP, 다층 퍼셉트론)

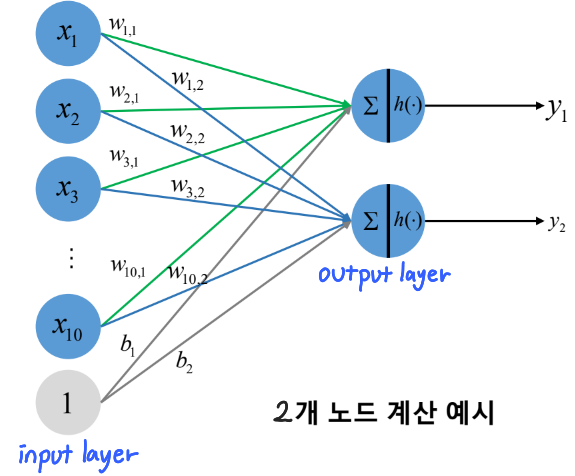

▪ 각 입력(x)에 대응되는 weight(w), 1개의 노드에 입력되는 bias(b)존재

▪ 가중합으로 얻어진 결과치에 활성화 함수(h) 적용

▪ 층 수 : 2개 이상

→ hidden layer가 1개이면 얕은 신경망, hidden layer가 2개 이상이면 깊은 신경망

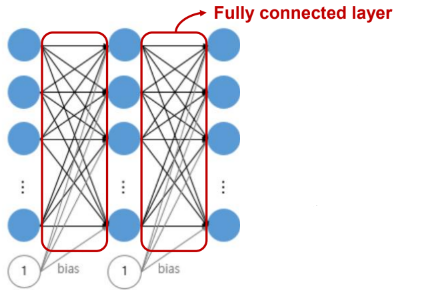

Fully Connected layer (FC layer, 전 결합 계층)

▪ 각 층별로 모든 노드가 연결되어 weight를 가지는 계층

▪ 한 층의 모든 노드가 다음 층의 모든 노드와 완전히 연결된 상태

ex) input nodes=10, hidden nodes=10 output nodes=20

Q. 2-layer perceptron에서 가지는 weight(w)의 개수는?

A. 300

Q. 2-later perceptron에서 가지는 bias(b)의 개수는?

A. 30

'머신러닝' 카테고리의 다른 글

| Support Vector Machine : Gradient Decent Method (GD) (1) | 2023.12.18 |

|---|---|

| Support Vector Machine : Quadratic Programming(2차 계획법) (0) | 2023.12.18 |

| MNIST Classification using SLP, MLP (1) | 2023.12.17 |

| [머신러닝] Loss Function, Optimization, Batch size (2) | 2023.11.24 |

| [머신러닝] Activation Function (0) | 2023.11.17 |